(23.04.03) Vision Language Model 논문 리뷰 1탄 논문 제목: Learning Transferable Visual Models From Natural Language Supervision (2021) - https://arxiv.org/pdf/2103.00020.pdf 기존 state-of-art computer vision systems - 고정되어있는 object 카테고리에서 예측하고 학습. -> 제한되어있는 supervision 형태로 인해 제한되는 부분들 발생. -> 자연어를 사용하여 image representation learning하는 것은 어떨까? ====> natural language supervision CLIP 1) contrastive pre-trainin..

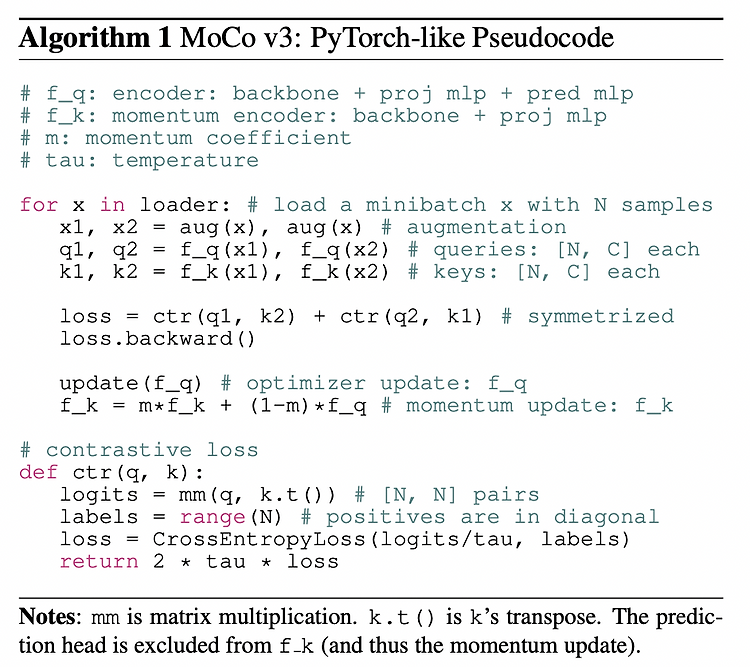

(23.02.08) SSL(self-supervised learning) 논문 리뷰 7탄 self supervised learning에 ViT backbone을 사용한 논문이다..! 기존 MoCo의 일부분이 변경되었다. - 논문 제목: An Empirical Study of Training Self-Supervised Vision Transformers (ICCV 2021) - https://arxiv.org/pdf/2104.02057.pdf Abstract & Introduction 본 논문에서 다루고자하는 것은 self-supervised learning for Vision Tranformers (ViT) 이다. 더보기 NLP와 vision 의 차이점은 2가지이다. - NLP는 maksed auto-..

(23.01.25) medical ai 논문 리뷰 4탄 이번에 정리할 논문은 3D medical image segmentation task에 transformer를 적용한 논문이다. - 논문 제목: UNETR: Transformers for 3D Medical Image Segmentation (2021) - https://arxiv.org/pdf/2103.10504v3.pdf Abstract 저자는 UNEt TRansformers (UNETR)를 제안한다. - sequence representiation을 학습하고, global multi scale information을 포착하기 위해 transformer를 encoder로 사용한다. - encoder와 decoder 아키텍쳐로는 U-shapped n..

(23.01.25) medical ai 논문 리뷰 3탄 이번에 정리할 논문은 UNet과 transformer를 합한 형태를 제안하며, medical image segmentation를 수행한다. UNet과 transformer에 대한 사전 지식을 갖고 읽어야한다. - 논문 제목: Transformers Make Strong Encoders for Medical Image Segmentation (2021) - https://arxiv.org/pdf/2102.04306.pdf Abstract - medical image segmentation 에서는 U-Net이 사실상 표준으로 사용되었는데, U-Net은 long-range dependency 문제가 있다. - transformer는 sequence-to-..

(23.01.22) ViT 논문 정리 1탄 computer vision에 transformer 열풍을 불러일으킨 논문이다. transformer관련 지식이 없어서 관련 이전 논문들을 읽고 읽었다. - 논문 제목: An Image Is Worth 16x16 Words: Transformers For Image Recognition At Scale (ICLR 2021) - https://arxiv.org/pdf/2010.11929.pdf Abstract - transformer 아키텍쳐는 nlp task에서 기본이 된 반면, computer vision 분야에서는 적용에 한계가 있었다. - 그러나, CNN에 의존할 필요가 없으며, pure transformer를 image patches의 sequence로 ..