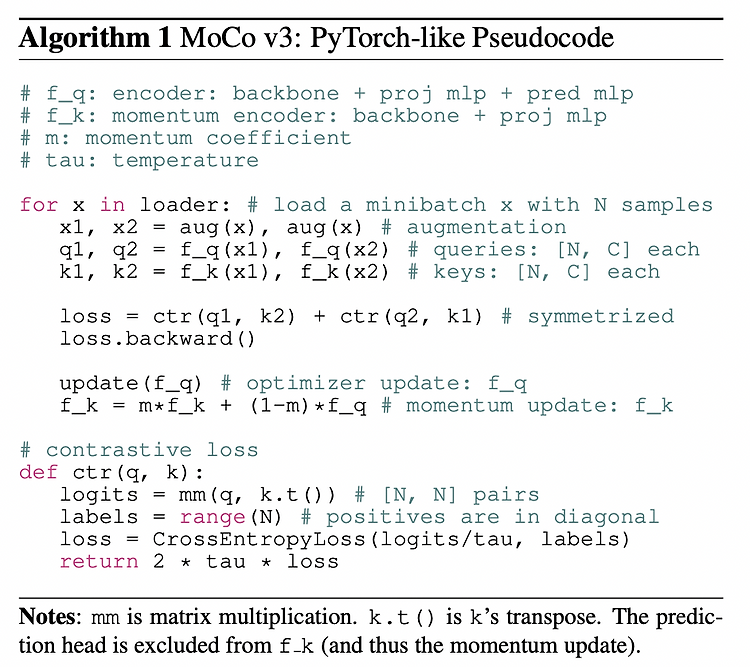

(23.02.08) SSL(self-supervised learning) 논문 리뷰 7탄 self supervised learning에 ViT backbone을 사용한 논문이다..! 기존 MoCo의 일부분이 변경되었다. - 논문 제목: An Empirical Study of Training Self-Supervised Vision Transformers (ICCV 2021) - https://arxiv.org/pdf/2104.02057.pdf Abstract & Introduction 본 논문에서 다루고자하는 것은 self-supervised learning for Vision Tranformers (ViT) 이다. 더보기 NLP와 vision 의 차이점은 2가지이다. - NLP는 maksed auto-..

(23.02.08) SSL(self-supervised learning) 논문 리뷰 6탄 논문이 3페이지여서 굉장히 빨리 읽을 수 있었다 ^ㅡ^ SimCLR + MoCo ..!! 라고 생각하면 될 것 같다..! - 논문 제목: Improved Baselines with Momentum Contrastive Learning (2020) - https://arxiv.org/pdf/2003.04297.pdf Abstract & Introduction Contrastive unsupervised learning -> SimCLR, MoCo 본 논문에서는 SimCLR의 2가지를 MoCo에 적용하여 MoCo v2를 제안한다. MLP projection head + data augmentation (이는 SimCLR..

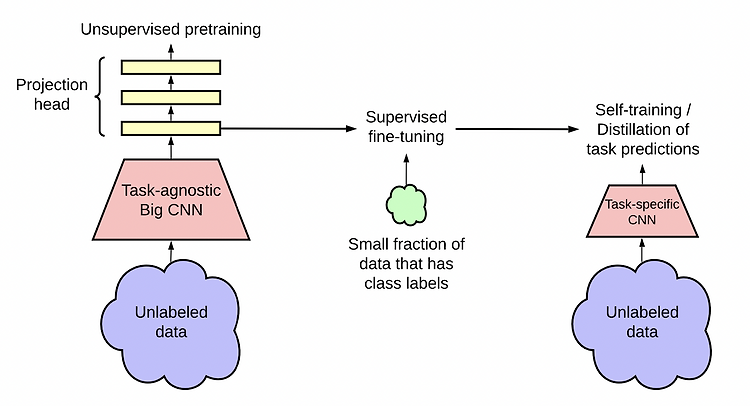

(23.02.08) SSL(self-supervised learning) 논문 리뷰 5탄 self-supervised learning + semi supervised learning의 내용을 담고 있는 논문이다. SimCLR의 성능을 높여줄 뿐만 아니라 semi-supervised learning에서도 sota를 달성했다. - 논문 제목: Big Self-Supervised Models are Strong Semi-Supervised Learners (NeurIPS 2020) - https://arxiv.org/pdf/2006.10029.pdf Abstract & Introduction 적은 labeled data를 통해 많은 양의 unlabeled data를 잘 사용하기 위한 paradigm은 바로 "..

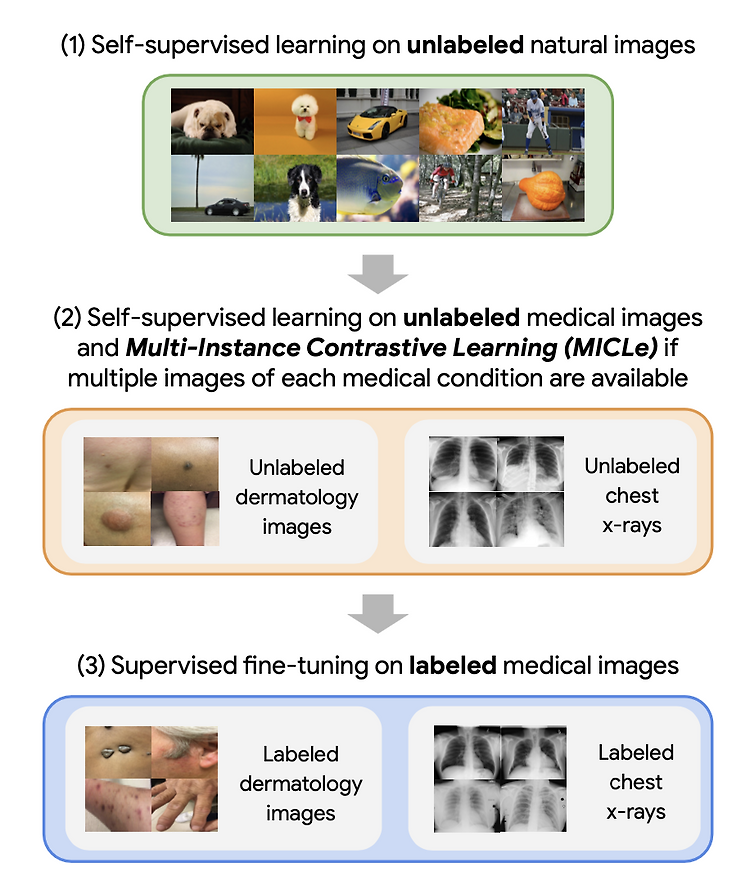

(23.01.20) medical ai 논문 리뷰 1탄 처음으로 정리할 medicial 분야의 ai 논문은 MICLe라고 불리는 논문인데, Self-supervised learning을 적용한 논문이다. SimCLR을 알고 읽는다면, 빠르게 읽을 수 있다. - 논문 제목: Big Self-Supervised Models Advance Medical Image Classifications (ICCV 2021) - https://arxiv.org/pdf/2101.05224.pdf Abstracts 이 논문은 2가지의 classification task에 대해 다룬다. 1. Dermatology domain: skin condition classification from digital camer images ..

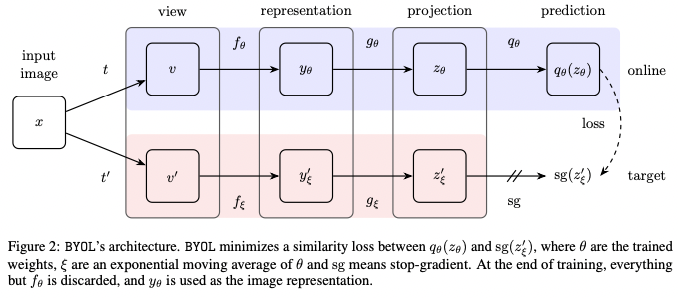

(23.01.17) SSL(self-supervised learning) 논문 리뷰 3탄 이번에 정리할 논문은 BYOL라 불리는 논문이다. - 논문 제목: Bootstrap Your Own Latent A New Approach to Self-Supervised Learning (NeurIPS 2020) - https://arxiv.org/pdf/2006.07733.pdf Abstract - 저자는 self-supervised image representation learning의 새로운 접근 방식인 BYOL 을 제안한다. - BYOL은 2개의 neural networks로 구성되며 이는 각각 online, target network로 불린다. - augmented view of an image에 대해서..

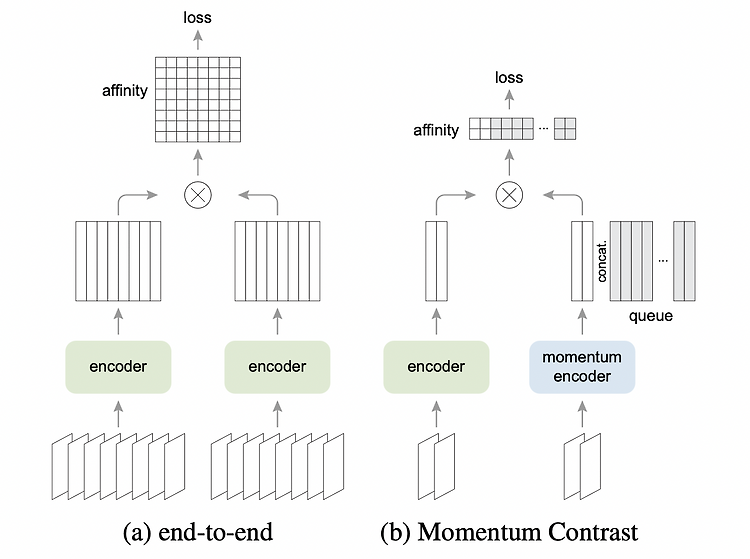

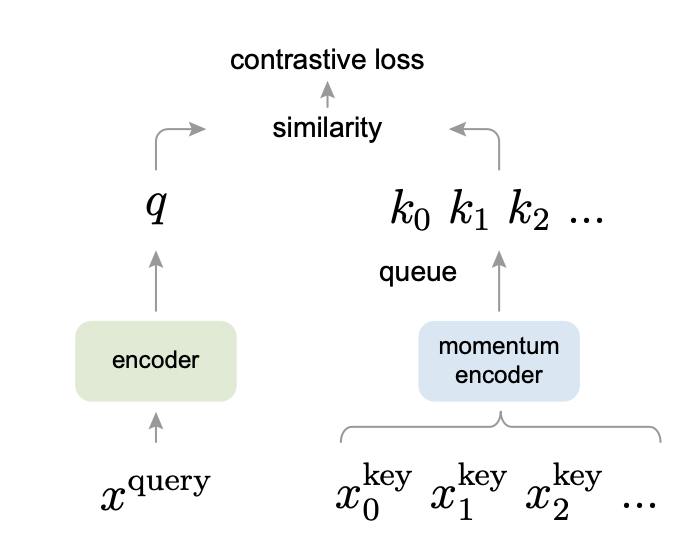

(23.01.17) SSL(self-supervised learning) 논문 리뷰 2탄 이번에 정리할 논문은 MoCo라 불리는 논문이다. - 논문 제목: Momentum Contrast for Unsupervised Visual Representation Learning (CVPR 2020) - https://arxiv.org/pdf/1911.05722.pdf Abstract 저자는 Momentum Contrast for unsupervised visual representation learning, 즉 MoCo 를 제안한다. contrastive learning의 관점에서 dynamic dictionary를 queue로 구현하고, moving-average encoder를 사용한다. Method 간단..

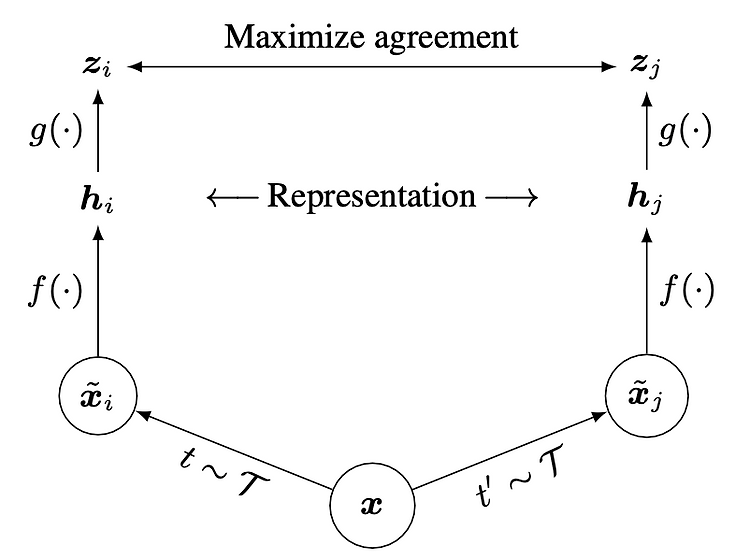

(23.01.17) SSL(self-supervised learning) 논문 리뷰 1탄 Self-supervised learing 에 대해 처음으로 리뷰할 논문은 SimCLR이라고 불리는 논문이다. - 논문 제목: A Single Framework for Contrastive Learning of Visual Representations (ICML 2020) - https://arxiv.org/pdf/1911.05722.pdf Abstract 저자는 3가지를 보여주는데, 아래와 같다. 1. self-supervised learning에서 data augmentations의 구성이 매우 중요한 역할을 한다. 2. representation과 contrastive loss 간의 learnable nonli..