(23.02.14) WSL(weakly supervised learning) 논문 리뷰 3탄 본 논문에서 제안하는 method가 연관 개념들이 굉장히 많이 들어간다. 성능개선이 있었지만, 간단한 mechanism은 아닌듯하다...! - 논문 제목: Self-supervised Equivariant Attention Mechanism for Weakly Supervised Semantic Segmentation (CVPR 2020) - https://arxiv.org/pdf/2004.04581v1.pdf 핵심 정리 - SEAM, PCM 제안. fully and weakly supervision의 gap을 줄이고자. - siamese network 구조로 구현, ECR(equivariant cross reg..

(23.02.12) WSL(weakly supervised learning) 논문 리뷰 2탄 사전지식이 별로 없는 상태에서 읽어서 이해하는데 조금 시간이 걸렸다. 논문 읽는 것에서 끝나지 않고, 코드를 봐야한다는 생각이 강력하게 드는 논문이다. - 논문 제목: Weakly-Supervised Semantic Segmentation Network with Deep Seeded Region Growing (CVPR 2018) -https://openaccess.thecvf.com/content_cvpr_2018/papers/Huang_Weakly-Supervised_Semantic_Segmentation_CVPR_2018_paper.pdf Weakly-supervised semantic segmentatio..

(23.02.12) DSRG 논문을 읽던 중, 처음보는 개념들이 나와서 찾아보았다...! seed region growing 방식을 개선하였다고 하는데, seed region growing 이란 무엇인가?? 참고 블로그 - https://blog.naver.com/laonple/220890216653 Region 기반 segmentation segmentation은 2가지 방식이 있다. 1. edge 기반 2. region 기반 edge 기반의 segementation은 image에서 차이가 있는 부분을 집중적으로 봤다면, region 기반의 segmentation은 image에서 비슷한 속성을 집중적으로 보는 방식이다. -> similarity region 기반에서 말하는 비슷한 속성은 밝기, 색상, ..

(23.02.09) WSL(weakly supervised learning) 논문 리뷰 1탄 CAM을 읽어보았다...! 꽤나 오래된 논문이지만, 아직도 꾸준히 인용되고 있다. - 논문 제목: Learning Deep Features for Discriminative Localization (CVPR 2016) - https://arxiv.org/pdf/1512.04150v1.pdf Problem & Solution Problem - CNN이 좋은 성능을 내는데, 이것이 왜 좋은 성능을 내는지 쉽게 설명할 수 없다는 black-box 문제가 있다. Solution - CAM을 제안하여 CNN이 어떻게 task를 수행하는지 설명할 수 있게 된다. -> 즉, CNN이 어떤 부분을 보고 예측했는지를 알려주는 역..

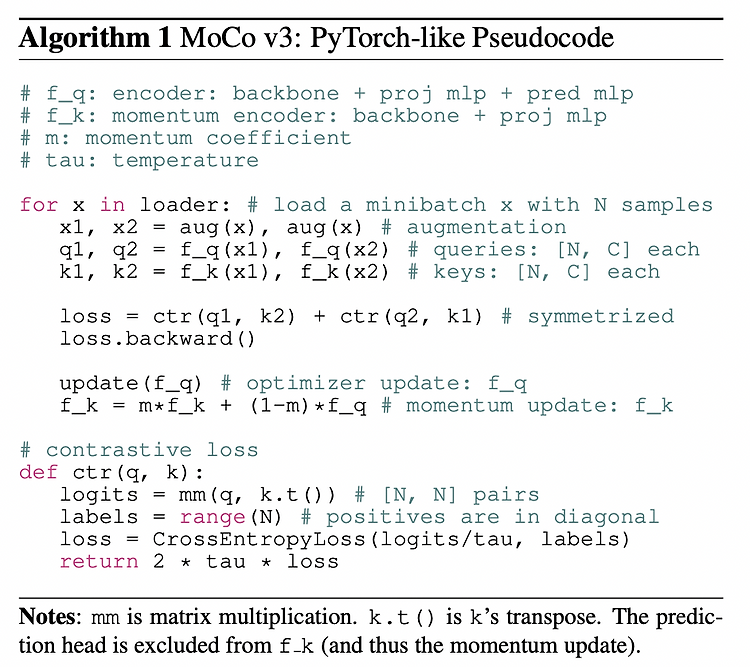

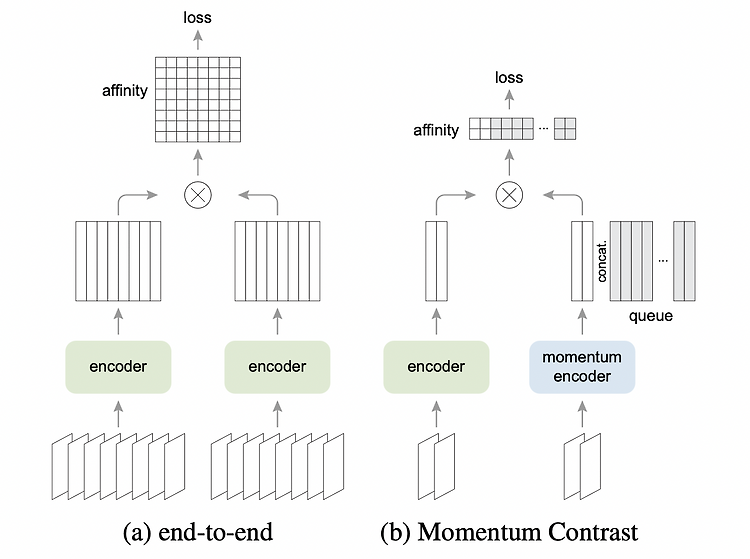

(23.02.08) SSL(self-supervised learning) 논문 리뷰 7탄 self supervised learning에 ViT backbone을 사용한 논문이다..! 기존 MoCo의 일부분이 변경되었다. - 논문 제목: An Empirical Study of Training Self-Supervised Vision Transformers (ICCV 2021) - https://arxiv.org/pdf/2104.02057.pdf Abstract & Introduction 본 논문에서 다루고자하는 것은 self-supervised learning for Vision Tranformers (ViT) 이다. 더보기 NLP와 vision 의 차이점은 2가지이다. - NLP는 maksed auto-..

(23.02.08) SSL(self-supervised learning) 논문 리뷰 6탄 논문이 3페이지여서 굉장히 빨리 읽을 수 있었다 ^ㅡ^ SimCLR + MoCo ..!! 라고 생각하면 될 것 같다..! - 논문 제목: Improved Baselines with Momentum Contrastive Learning (2020) - https://arxiv.org/pdf/2003.04297.pdf Abstract & Introduction Contrastive unsupervised learning -> SimCLR, MoCo 본 논문에서는 SimCLR의 2가지를 MoCo에 적용하여 MoCo v2를 제안한다. MLP projection head + data augmentation (이는 SimCLR..

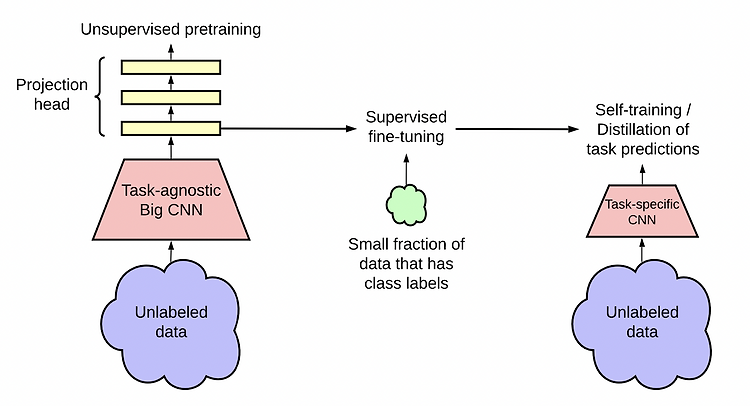

(23.02.08) SSL(self-supervised learning) 논문 리뷰 5탄 self-supervised learning + semi supervised learning의 내용을 담고 있는 논문이다. SimCLR의 성능을 높여줄 뿐만 아니라 semi-supervised learning에서도 sota를 달성했다. - 논문 제목: Big Self-Supervised Models are Strong Semi-Supervised Learners (NeurIPS 2020) - https://arxiv.org/pdf/2006.10029.pdf Abstract & Introduction 적은 labeled data를 통해 많은 양의 unlabeled data를 잘 사용하기 위한 paradigm은 바로 "..

(23.01.27) Murphy_Machine_Learning 교재 참고 KL divergence 설명 잘해놓은 블로그: https://brunch.co.kr/@chris-song/69#comment Inforamtion theory information theory의 핵심 아이디어: 자주 일어나지 않는 사건이 자주 발생하는 사건보다 정보량이 많다. 여기서 말하는 정보량을 식으로 나타낸 것이 바로 아래의 식이다. 발생활 확률 p(x)이 큰 사건은 정보량 I(x)가 적고, 발생할 확률 p(x)이 작은 사건은 정보량 I(x)가 크다. 위 정보량 식에서 log의 밑이 2일 때, 정보량의 단위는 bit이고, log의 밑이 e일 때, 정보량의 단위는 natural unit (nat)이다. Entropy entro..

(23.01.27) 선형대수 정리하기 3탄 Identity matrix, inverse matrix, diagonal matrix Rank Null space Ax=b 의 해의 수

(23.01.27) 선형대수 정리하기 2탄 굿노트에 정리한 거를 티스토리에 옮기는 느낌이다,,ㅎㅎ Norm 아래는 간단한 예시를 그림으로 표현한 것이다. 행렬의 곱셈, 행렬의 곱셈의 4가지 관점 연립일차방정식을 행렬과 벡터의 곱으로 표현할 수 있는 것 처럼, 두개의 연립일차방정식을 행렬과 행렬의 곱으로 표현할 수 있다. 행렬 곱셈의 4가지 관점은 아래와 같다. Span, Basis (+ linear combination, linear independent) 선형독립 (23.04.01) 선형독립/선형종속 과 singular/non-singular matrix 정리

(23.01.27) 선형대수 정리하기 1탄 행렬의 기본 개념 행(row)는 가로, 열(column)은 세로라고 생각하면 된다. => 가로 2줄, 세로 3줄의 행렬은 2x3 크기를 가진 행렬이다. 행으로만 이루어진 벡터, 즉 가로만 있는 벡터를 row vector (행벡터)라고 부르고, 열로만 이루어진 벡터, 즉 세로만 있는 벡터를 column vector (열벡터)라고 부른다. 어떤 실수 a,b에 대해서 위의 식으로 2차원 좌표평면의 모든 것을 표현할 수 있다. Transpose - 전치 전치는 어렵지 않은 개념인데, 행렬에서 하나의 요소를 a_ij라고 표현했을 때, 전치시키면 같은 자리의 요소가 모두 a_ji가 된다. 즉, 오른쪽 아래 방향의 대각선은 그대로 있게 된다. (i와 j가 같은 숫자니까) 전..

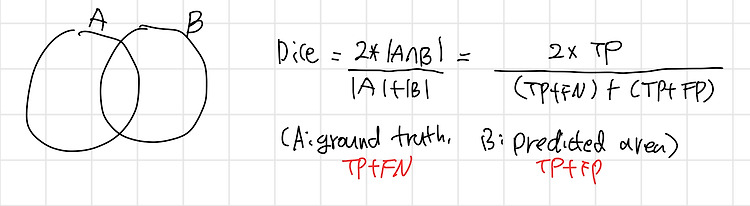

(23.01.25) segmentation 에서 평가지표로 쓰이는 IoU와 dice score에 대하여 정리해보았다. (23.02.17) mIoU 내용 추가 IoU와 Dice score은 ground truth와 predicted area 두 영역이 얼마나 겹쳐있는지를 나타내는 지표이다. IoU (intersection over union) ground truth를 A, predicted area를 B라고 했을 때, IoU는 위와 같다. IoU의 값은 0~1 사이이고, IoU의 값이 클수록, 즉 1에 가까울수록 좋은 성능의 모델이라 판단할 수 있다. MIoU (mean IoU) segmentation에서는 각 class에 대한 IoU를 계산하고, 평균을 취한 MIoU를 사용한다. Dice coeffici..

(23.01.25) medical ai 논문 리뷰 4탄 이번에 정리할 논문은 3D medical image segmentation task에 transformer를 적용한 논문이다. - 논문 제목: UNETR: Transformers for 3D Medical Image Segmentation (2021) - https://arxiv.org/pdf/2103.10504v3.pdf Abstract 저자는 UNEt TRansformers (UNETR)를 제안한다. - sequence representiation을 학습하고, global multi scale information을 포착하기 위해 transformer를 encoder로 사용한다. - encoder와 decoder 아키텍쳐로는 U-shapped n..

(23.01.25) medical ai 논문 리뷰 3탄 이번에 정리할 논문은 UNet과 transformer를 합한 형태를 제안하며, medical image segmentation를 수행한다. UNet과 transformer에 대한 사전 지식을 갖고 읽어야한다. - 논문 제목: Transformers Make Strong Encoders for Medical Image Segmentation (2021) - https://arxiv.org/pdf/2102.04306.pdf Abstract - medical image segmentation 에서는 U-Net이 사실상 표준으로 사용되었는데, U-Net은 long-range dependency 문제가 있다. - transformer는 sequence-to-..

(23.01.25) medical ai 논문 리뷰 2탄 - 논문 제목: Convolutional Networks for Biomedical Image Segmentation (MICAAI 2015) - https://arxiv.org/pdf/1505.04597.pdf (Segmentation) 많은 visual task가 있지만, biomedical image segmentation은 각 pixel 별로 class label을 매겨줘야하는 localization이 필요하다. H x W x RGB_channel -> model -> H x W x class Abstract - data augmentation 중요하다. - 본 논문에서 제안하는 아키텍쳐는 end-to-end train 가능하다. - cont..