(23.03.18)

이번에는 퍼셉트론을 이용한 AND, OR, NOR, XOR gate 연산, forward/backward propagation, activation function 에 대해 정리해보았다.

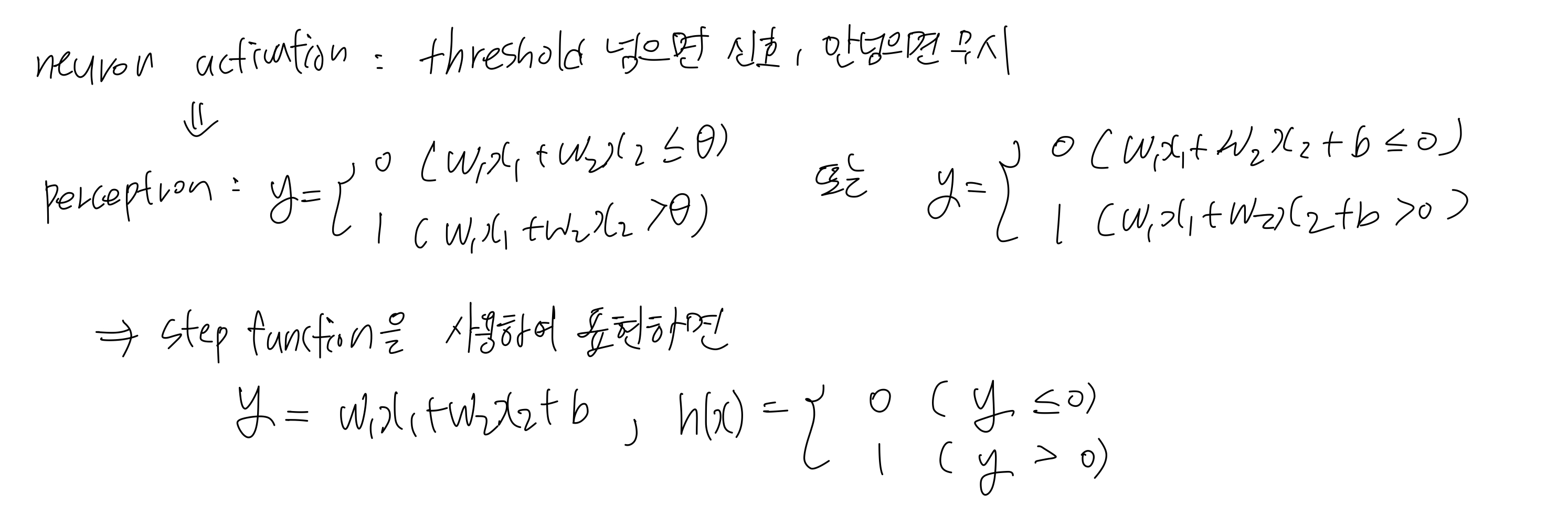

Perceptron

- 입력 신호에 가중치가 곱해지고, 그 값들이 더해져 최종적으로 출력한다.

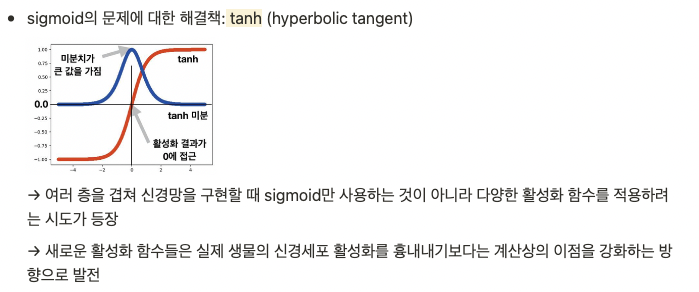

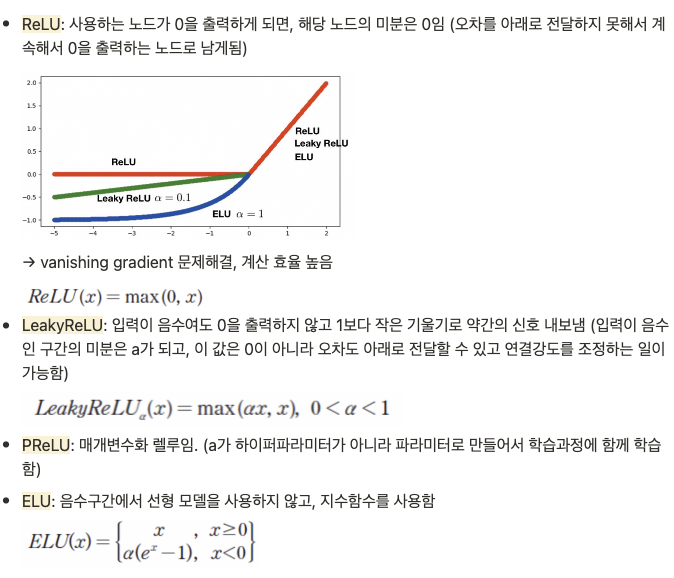

- 활성화 함수: 출력 노드에 모인 신호들을 내보낼 때, 얼마나 강하게 내보낼지 정하는 함수로 (sigmoid, ReLU 등이 있다)

- perceptron의 학습: 출력값과 목표값을 비교하여 나오는 오차를 줄이는 방향으로 가중치(w)를 조절하는 것

- hyperparameter: w의 조정 정도 (learning rate), loss function을 무엇으로 정할 것인지,

----> weight (parameter) 는 모델의 동작을 결정하고, hyperparameter는 학습 과정을 조절한다.

- perceptron은 XOR 연산을 구현하지 못한다는 문제가 있다.

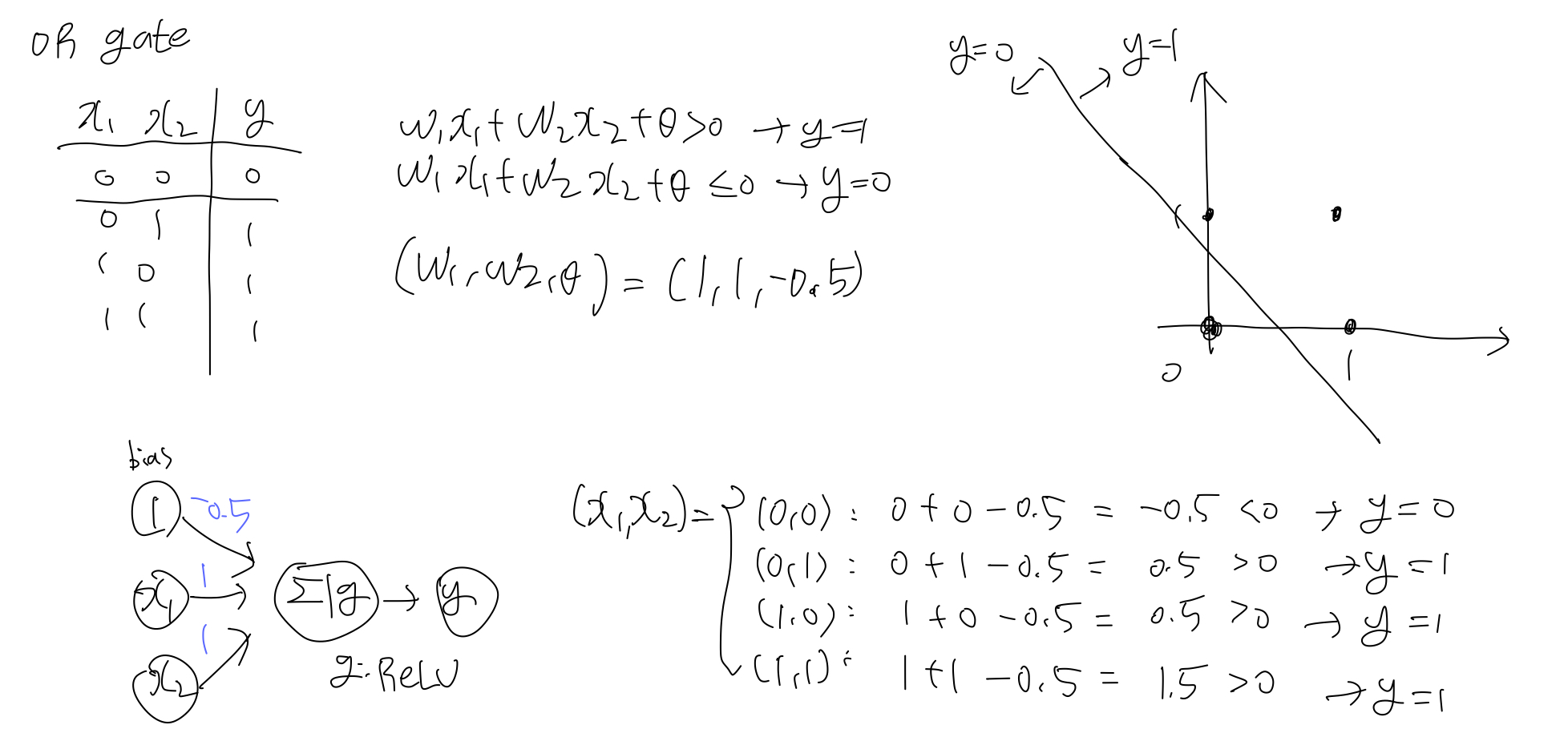

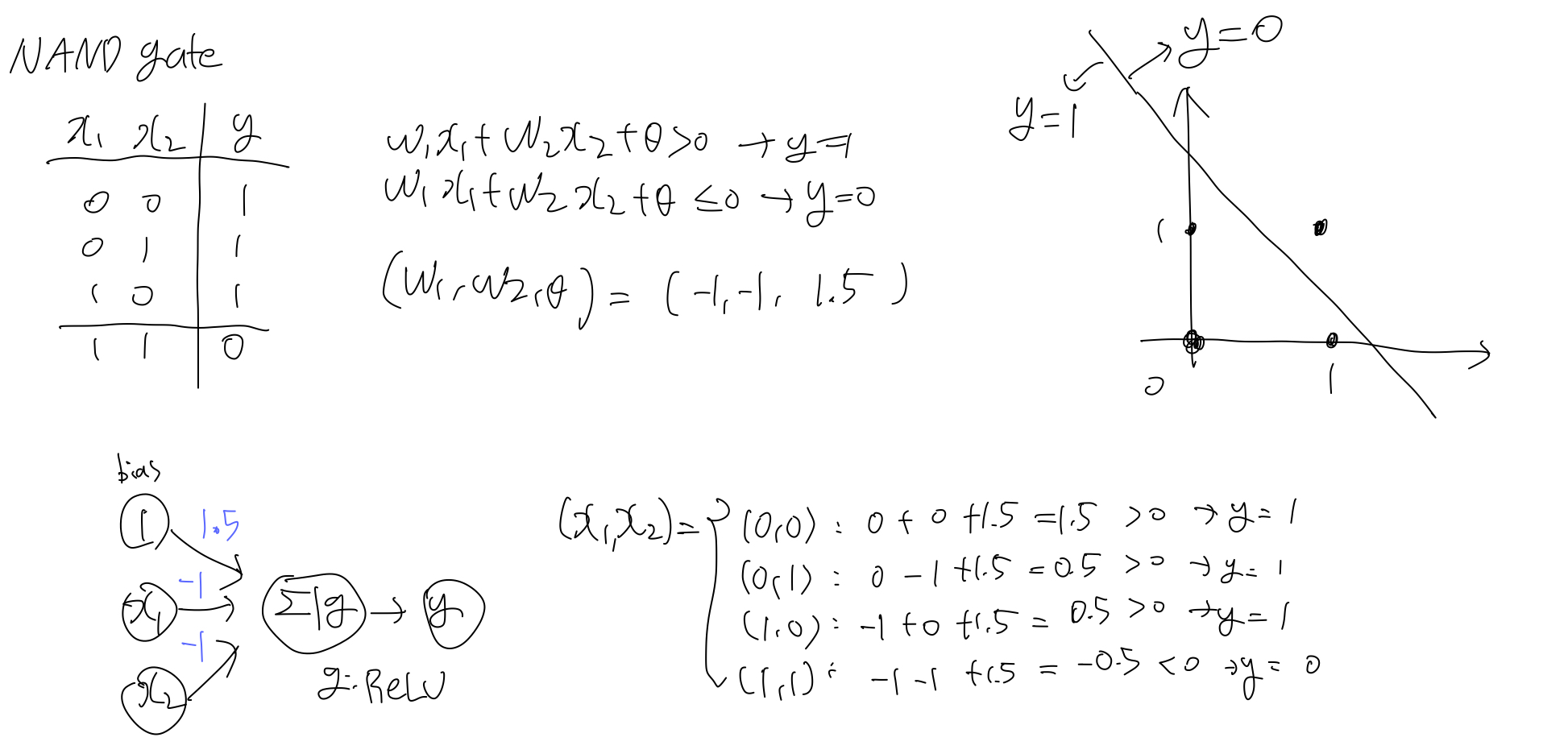

perceptron으로 AND, OR, NAND, NOR gate 표현하기

(activation function: ReLU)

multi-layer perceptron

- 단층 퍼셉트론은 가중치를 이용하여 학습이 가능하지만, 선형 분리만 가능하다. XOR gate와 같은 선형분리가 아닌 연산은 수행하지 못한다는 문제를 해결하고자 나온 것이 Multi-layer perceptron이다. => 여러 층을 사용하자!!

- input layer, hidden layer, ouput layer로 구성되어있다.

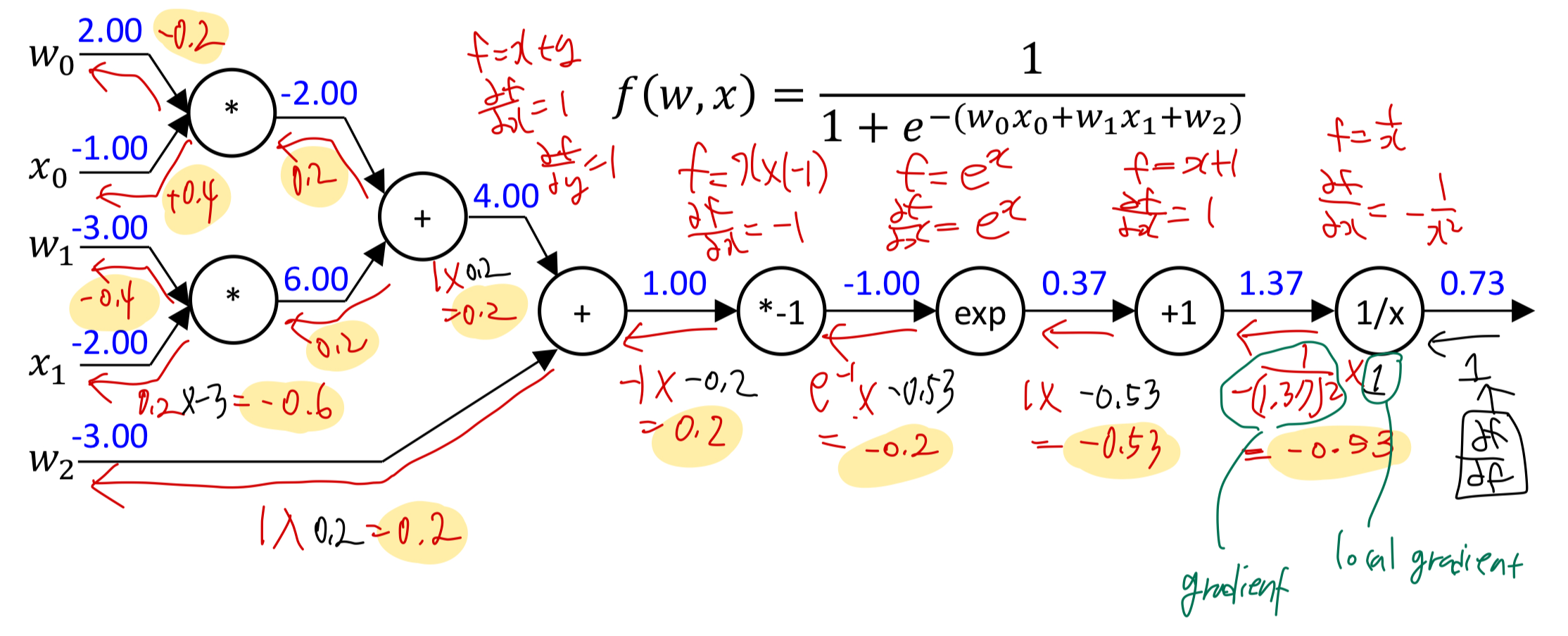

- 입력 값과 가중치를 계산하고 합하고, 최종 출력층으로 계산하는 forward propagation 을 진행하며, 최종 출력값과 실제값(목표값)의 오차를 계산하여 가중치를 업데이트하는 back propagation 을 수행한다.

- 그러나 layer를 너무 깊게 쌓을 경우, back propagation (역전파)를 진행할 때, 가중치가 손실되는 gradient vanishing 문제가 발생할 수 있다.

back propagation

multi-layer perceptron으로 XOR gate 표현하기

(activation function : ReLU)

activation function

(노션에 정리해두었던 내용)