(23.03.17)

Multivariate Linear Regression : 다변량 선형 회귀

- linear regression에서는 feature가 하나였다면, multivariate linear regression에서는 feature가 여러 개이다.

가설함수, 손실함수, 경사하강법에 관련된 식들을 정리하면 아래와 같다.

Locally-weighted linear regression

- linear model을 여러 개 사용해서 non-linear predeictions 처럼 만들어주는 방법이다.

- loss funciton은 아래와 같다.

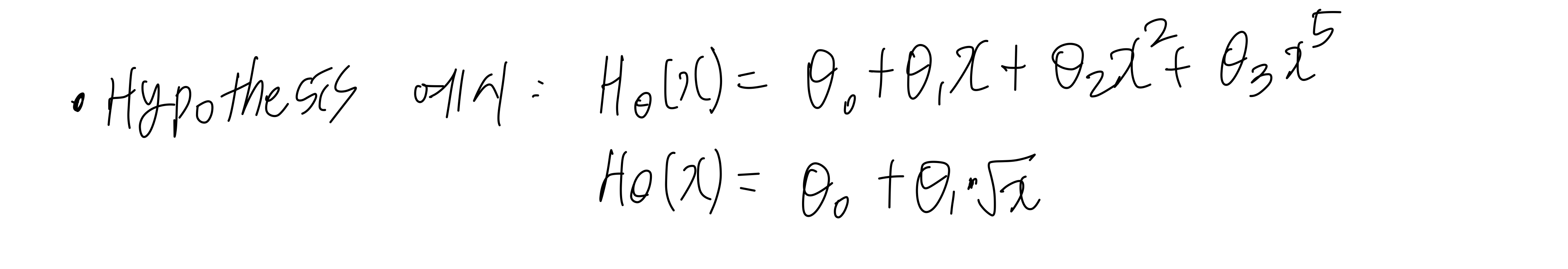

polynomial regression : 다항 회귀

- 다항 회귀는 feature는 하나인데, 가설함수 linear하지 않다. feature인 x의 지수가 다양하다.

- polynomial regression에서는 feature scaling이 중요하다.

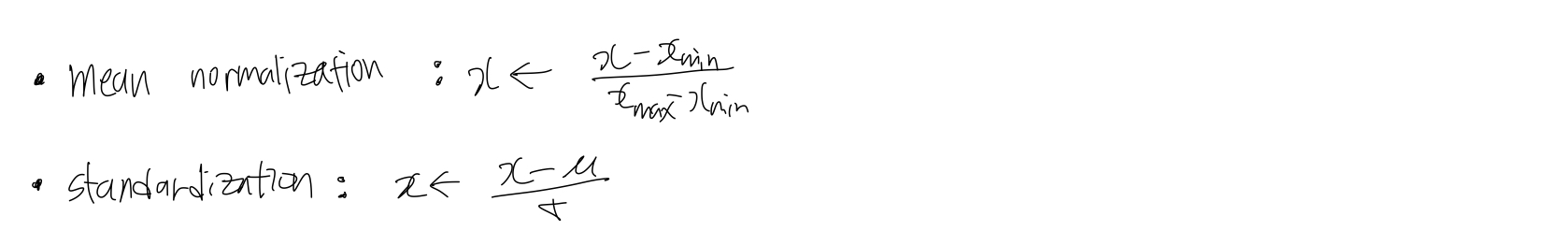

---> feature scaling은 feature들이 서로 비슷한 규모를 가지도록 하기 위한 것으로 보통 -1과 1사이의 범위에 속하도록 만든다.

- mean normalization은 입력값을 0~1 사이로 변환한다.

- standardization은 입력값을 평균은 0, 분산은 1인 표준정규분포로 변환한다.

728x90

'Computer Science > Machine Learning' 카테고리의 다른 글

| [machine learning] 4. Softmax regression (multi-class classification) (0) | 2023.03.18 |

|---|---|

| [machine learning] 3. Logistic Regression (binary classification) (0) | 2023.03.18 |

| [machine learning] 1. Linear Regression (gradient descent, mini-batch gradient descent, normal equation) (0) | 2023.03.17 |

| [machine learning] 0. Introduction (0) | 2023.03.17 |

| [ML] 비지도학습 - 군집화(clustering) (0) | 2022.04.09 |